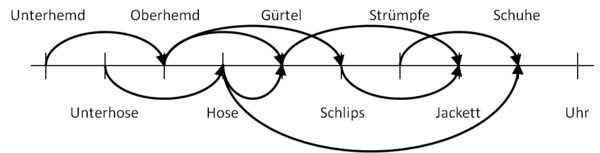

Graphen und Graphenalgorithmen: Difference between revisions

| (192 intermediate revisions by 3 users not shown) | |||

| Line 17: | Line 17: | ||

O | O | ||

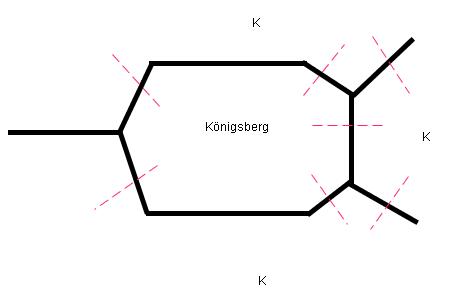

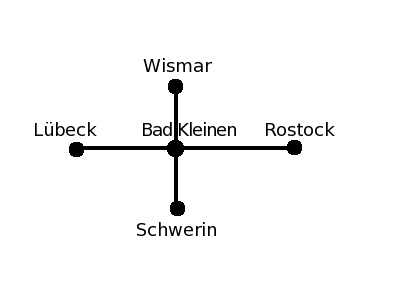

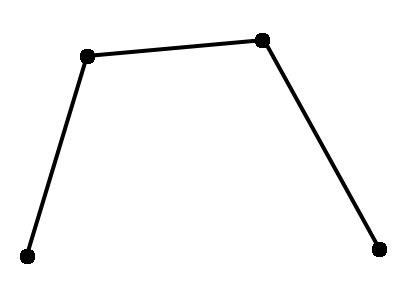

Der gesuchte Spaziergang würde existieren, wenn es maximal 2 Knoten gäbe, an denen sich eine ungerade Zahl von Kanten trifft. Die Frage muss für Königsberg also verneint werden, denn hier gibt es vier solche Knoten. | Der gesuchte Spaziergang würde existieren, wenn es maximal 2 Knoten gäbe, an denen sich eine ungerade Zahl von Kanten trifft. Die Frage muss für Königsberg also verneint werden, denn hier gibt es vier solche Knoten. Ein leicht modifiziertes Problem ist allerdings lösbar: Im obigen Stadtplan erkennt man eine Fähre, die die Stadtteile Kneiphof und Altstadt verbindet. Bezieht man dieselbe in den Spaziergang ein, ergibt sich folgender Graph, bei dem nur noch zwei Knoten mit ungerader Kantenzahl existieren: | ||

Inzwischen haben Graphen | --O | ||

/ /| \ | |||

\ \| \ | |||

--O---O | |||

/| / | |||

\| / | |||

O | |||

Inzwischen haben Graphen eine riesige Zahl weiterer Anwendungen gefunden. Einige Beispiele: | |||

* Landkarten: | * Landkarten: | ||

| Line 319: | Line 327: | ||

... # do something with neighbor | ... # do something with neighbor | ||

Die Adjazenzlistendarstellung ist effizienter, wenn der Graph nicht dicht ist, so dass viele Einträge der Adjazenzmatrix Null wären. | Die Adjazenzlistendarstellung ist effizienter, wenn der Graph nicht dicht ist, so dass viele Einträge der Adjazenzmatrix Null wären. In der Vorlesung werden wir nur diese Darstellung verwenden. | ||

;Transponierter Graph: Den ''transponierten Graphen'' G<sup>T</sup> eines gerichteten Graphen G erhält man, wenn man alle Kantenrichtungen umkehrt. | ;<div id="transposed_graph">Transponierter Graph</div>: Den ''transponierten Graphen'' G<sup>T</sup> eines gerichteten Graphen G erhält man, wenn man alle Kantenrichtungen umkehrt. | ||

Bei ungerichteten Graphen hat die Transposition offensichtlich keinen Effekt, weil alle Kanten bereits in beiden Richtungen vorhanden sind, so dass G<sup>T</sup> = G gilt. Bei gerichteten Graphen ist die Transposition | Bei ungerichteten Graphen hat die Transposition offensichtlich keinen Effekt, weil alle Kanten bereits in beiden Richtungen vorhanden sind, so dass G<sup>T</sup> = G gilt. Bei gerichteten Graphen ist die Transposition einfach, wenn der Graph als Adjazenzmatrix implementiert ist, weil man einfach die transponierte Adjazenzmatrix verwenden muss (beachte, dass sich die Reihenfolge der Indizes umkehrt): | ||

:::A<sup>T</sup> = a<sub>ji</sub> | :::A<sup>T</sup> = a<sub>ji</sub> | ||

Ist der Graph hingegen durch eine Adjazenzliste repräsentiert, muss etwas mehr Aufwand getrieben werden: | Ist der Graph hingegen durch eine Adjazenzliste repräsentiert, muss etwas mehr Aufwand getrieben werden: | ||

def | def transposeGraph(graph): | ||

gt = [[] for k in graph] # zunächst leere Adjazenzlisten von G<sup>T</sup> | gt = [[] for k in graph] # zunächst leere Adjazenzlisten von G<sup>T</sup> | ||

for node in range(len(graph)): | for node in range(len(graph)): | ||

| Line 336: | Line 344: | ||

== Durchlaufen von Graphen (Graph Traversal) == | == Durchlaufen von Graphen (Graph Traversal) == | ||

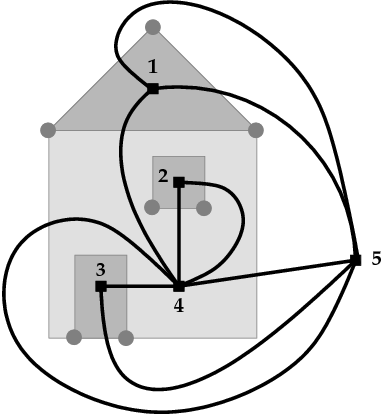

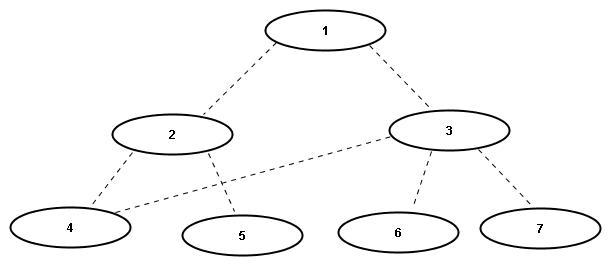

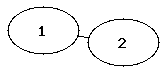

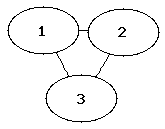

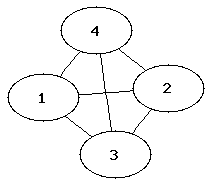

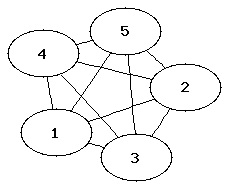

Wir betrachten zunächst ungerichtete Graphen mit V Knoten und E Kanten. Eine grundlegende Aufgabe in diesen Graphen besteht darin, alle Knoten in einer bestimmten Reihenfolge genau einmal zu besuchen. Hierbei darf man sich von einem gegebenen Startknoten aus nur entlang der Kanten des Graphen bewegen. Die beim Traversieren benutzen Kanten bilden einen Baum, dessen Wurzel der Startknoten ist und der den gesamten Graphen aufspannt, falls der Graph zusammenhängend ist. (Beweis: Da jeder Knoten nur einmal besucht wird, gibt es für jeden besuchten Knoten [mit Ausnahme des Startknotens] genau eine eingehende Kante. Ist der Graph zusammenhängend, wird jeder Knoten tatsächlich erreicht | Wir betrachten zunächst ungerichtete Graphen mit V Knoten und E Kanten. Eine grundlegende Aufgabe in diesen Graphen besteht darin, alle Knoten in einer bestimmten Reihenfolge genau einmal zu besuchen. Hierbei darf man sich von einem gegebenen Startknoten aus nur entlang der Kanten des Graphen bewegen. Die beim Traversieren benutzen Kanten bilden einen Baum, dessen Wurzel der Startknoten ist und der den gesamten Graphen aufspannt, falls der Graph zusammenhängend ist. (Beweis: Da jeder Knoten nur einmal besucht wird, gibt es für jeden besuchten Knoten [mit Ausnahme des Startknotens] genau eine eingehende Kante. Ist der Graph zusammenhängend, wird jeder Knoten tatsächlich erreicht und es gibt genau (V-1) Kanten, exakt soviele wie für einen Baum mit V Knoten notwendig sind.) Ist der Graph nicht zusammenhängend, wird jeder zusammenhängende Teilgraph (jede <i>Zusammenhangskomponente</i>) getrennt traversiert, und man erhält einen sogenannten <i>Wald</i> mit einem Baum pro Zusammenhangskomponente. Die beiden grundlegenden Traversierungsmethoden <i>Tiefensuche</i> und <i>Breitensuche</i> werden im folgenden vorgestellt. | ||

=== Tiefensuche in Graphen (Depth First Search, DFS) === | === Tiefensuche in Graphen (Depth First Search, DFS) === | ||

Die Idee der Tiefensuche besteht darin, jeden | Die Idee der Tiefensuche besteht darin, jeden besuchten Knoten sofort über die erste Kante wieder zu verlassen, die zu einem noch nicht besuchten Knoten führt. Man findet dadurch schnell einen möglichst langen Pfad durch den Graphen, und der Traversierungs-Baum wird zunächst in die Tiefe verfolgt, daher der Name des Verfahrens. Hat ein Knoten keine unbesuchten Nachbarknoten mehr, geht man im Baum auf demselben Weg zurück (sogenanntes <i>back tracking</i>), bis man einen Knoten findet, der noch einen unbesuchten Nachbarn besitzt, und traversiert diese nach dem gleichen Muster. Gibt es gar keine unbesuchten Knoten mehr, kehrt die Suche zum Startknoten zurück und endet dort. | ||

Die folgende rekursive Implementation der Tiefensuche erwartet den Graphen in Adjazenzlistendarstellung und beginnt die Suche beim Knoten <tt>startnode</tt>. Die Information, ob ein Knoten bereits besucht wurde, wird im Array <tt>visited</tt> gespeichert. Ein solches Array, das zusätzliche Informationen über die Knoten des Graphen bereitstellt, wir <i>property map</i> genannt. (Die Verwendung von property maps hat sich gegenüber der alternativen Idee durchgesetzt, solche Eigenschaften in speziellen Knotenklassen zu speichern. Im letzteren Fall braucht man nämlich für jede Anwendung eine angepasste Knotenklasse mit den jeweils gewünschten Attributen und damit auch angepasste Implementationen der Graphenfunktionen, was sich als sehr aufwändig erwiesen hat.) | |||

def dfs(graph, startnode): | def dfs(graph, startnode): | ||

visited = [ | visited = [False]*len(graph) # Flags, welche Knoten bereits besucht wurden | ||

def visit(node): # rekursive Hilfsfunktion, die den gegebenen Knoten und dessen Nachbarn besucht | def visit(node): # rekursive Hilfsfunktion, die den gegebenen Knoten und dessen Nachbarn besucht | ||

if visited[node] | if not visited[node]: # Besuche node, wenn er noch nicht besucht wurde | ||

visited[node] = True # Markiere node als besucht | visited[node] = True # Markiere node als besucht | ||

print node | print(node) # Ausgabe der Knotennummer - pre-order | ||

for neighbor in graph[node]: # Besuche rekursiv die Nachbarn | for neighbor in graph[node]: # Besuche rekursiv die Nachbarn | ||

visit(neighbor) | visit(neighbor) | ||

| Line 369: | Line 377: | ||

5 | 5 | ||

In dieser Version des Algorithmus werden die Knotennummern ausgegeben, bevor die Nachbarknoten besucht werden. Man bezeichnet die resultierende Sortierung der Knoten als < | <div id="pre_and_post_order">In dieser Version des Algorithmus werden die Knotennummern ausgegeben, bevor die Nachbarknoten besucht werden. Man bezeichnet die resultierende Sortierung der Knoten als <b>pre-order</b> oder als <b>discovery order</b>. Alternativ kann man die Knotennummern erst ausgeben, nachdem alle Nachbarn besucht wurden, also auf dem Rückweg der Rekursion. In diesem Fall spricht man von <b>post-order</b> oder <b>finishing order</b>:</div> | ||

def dfs(graph, startnode): | def dfs(graph, startnode): | ||

visited = [ | visited = [False]*len(graph) # Flags, welche Knoten bereits besucht wurden | ||

def visit(node): # rekursive Hilfsfunktion, die den gegebenen Knoten und dessen Nachbarn besucht | def visit(node): # rekursive Hilfsfunktion, die den gegebenen Knoten und dessen Nachbarn besucht | ||

if visited[node] | if not visited[node]: # Besuche node, wenn er noch nicht besucht wurde | ||

visited[node] = True # Markiere node als besucht | visited[node] = True # Markiere node als besucht | ||

for neighbor in graph[node]: # Besuche rekursiv die Nachbarn | for neighbor in graph[node]: # Besuche rekursiv die Nachbarn | ||

visit(neighbor) | visit(neighbor) | ||

<font color=red>print node | <font color=red>print(node) # Ausgabe der Knotennummer - post-order</font> | ||

visit(startnode) | visit(startnode) | ||

| Line 398: | Line 406: | ||

* Kopieren eines Graphen: kopiere zuerst den besuchten Knoten, dann seine Nachbarn und die dazugehörigen Kanten (sowie die Kanten zu bereits besuchten Knoten, die in der Grundversion der Tiefensuche ignoriert werden). | * Kopieren eines Graphen: kopiere zuerst den besuchten Knoten, dann seine Nachbarn und die dazugehörigen Kanten (sowie die Kanten zu bereits besuchten Knoten, die in der Grundversion der Tiefensuche ignoriert werden). | ||

* Bestimmen der Zusammenhangskomponenten eines Graphen (siehe unten) | * Bestimmen der Zusammenhangskomponenten eines Graphen (siehe unten) | ||

* In einem Zeichenprogramm: fülle eine Region mit einer Farbe ("flood fill"). Dabei ist jedes Pixel ein Knoten des Graphen und wird mit seinen 4 Nachbarpixeln verbunden. Die Tiefensuche startet bei der Mausposition und endet am Rand des betreffendcen Gebiets. | |||

* Falls der Graph ein Baum ist: bestimme den Abstand jedes Knotens von der Wurzel | * Falls der Graph ein Baum ist: bestimme den Abstand jedes Knotens von der Wurzel | ||

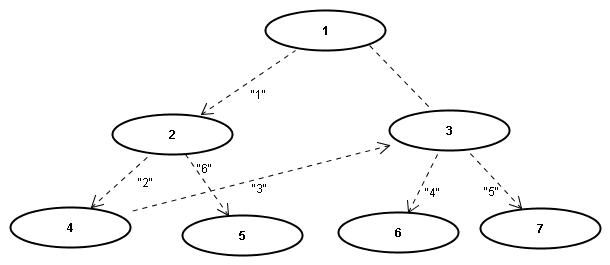

* Falls der Graph ein Parse-Baum ist, wobei innere Knoten Funktionsaufrufe, Kindknoten Funktionsargumente, und Blattknoten Werte repräsentieren: drucke den zugehörigen Ausdruck aus (also immer zuerst den Funktionsnamen, dann die Argumente, die wiederum geschachtelte Funktionsaufrufe sein können). | * Falls der Graph ein Parse-Baum ist, wobei innere Knoten Funktionsaufrufe, Kindknoten Funktionsargumente, und Blattknoten Werte repräsentieren: drucke den zugehörigen Ausdruck aus (also immer zuerst den Funktionsnamen, dann die Argumente, die wiederum geschachtelte Funktionsaufrufe sein können). | ||

| Line 409: | Line 418: | ||

Im Spezialfall, wenn der Graph ein Binärbaum ist, unterscheidet man noch eine dritte Variante der Traversierung, nämlich die <i>in-order</i> Traversierung. In diesem Fall behandelt man den Vaterknoten nach den linken, aber vor den rechten Kindern. Diese Reihenfolge wird beim [[Suchen#Beziehungen zwischen dem Suchproblem und dem Sortierproblem|Tree Sort Algorithmus]] verwendet. Diese Sortierung verwendet man auch, wenn man einen Parse-Baum mit binären Operatoren (statt Funktionsaufrufen) ausgeben will, siehe Übung 5. | Im Spezialfall, wenn der Graph ein Binärbaum ist, unterscheidet man noch eine dritte Variante der Traversierung, nämlich die <i>in-order</i> Traversierung. In diesem Fall behandelt man den Vaterknoten nach den linken, aber vor den rechten Kindern. Diese Reihenfolge wird beim [[Suchen#Beziehungen zwischen dem Suchproblem und dem Sortierproblem|Tree Sort Algorithmus]] verwendet. Diese Sortierung verwendet man auch, wenn man einen Parse-Baum mit binären Operatoren (statt Funktionsaufrufen) ausgeben will, siehe Übung 5. | ||

=== Breitensuche (Breadth First Search, BFS) === | Eine nützliche Erweiterung der Tiefensuche besteht darin, Informationen über den Verlauf der Suche zu sammeln und am Ende zurückzugeben, so dass andere Algorithmen diese Information nutzen können. Typische Beispiele dafür sind eine Reihenfolge der Knoten (in discovery oder finishing order) oder die Vorgänger jedes Knotens im Tiefensuchbaum (also von welchem Knoten aus man den jeweiligen Knoten zuerst erreicht hat). Wir führen dafür drei neue Arrays ein. | ||

def dfs(graph, startnode): | |||

visited = [False]*len(graph) # wurde ein Knoten bereits besucht? | |||

parents = [None]*len(graph) # registriere für jeden Knoten den Vorgänger im Tiefensuchbaum | |||

discovery_order = [] # enthält am Ende die pre-order Sortierung | |||

finishing_order = [] # enthält am Ende die post-order Sortierung | |||

def visit(node, parent): # rekursive Hilfsfunktion | |||

if not visited[node]: # besuche 'node', wenn noch nicht besucht wurde | |||

visited[node] = True # markiere 'node' als besucht | |||

parents[node] = parent # speichere den Vorgänger von 'node' | |||

discovery_order.append(node) # registriere, dass 'node' jetzt entdeckt wurde | |||

for neighbor in graph[node]: # besuche rekursiv die Nachbarn ... | |||

visit(neighbor, node) # ... wobei 'node' zu deren Vorgänger wird | |||

finishing_order.append(node) # registriere, dass 'node' jetzt fertiggestellt wurde | |||

visit(startnode, None) # beginne bei 'startnode', der keinen Vorgänger hat | |||

return parents, discovery_order, finishing_order # gib die zusätzliche Informationen zurück | |||

Beginnt man die Suche bei Knoten 1, entsprechen die Inhalte der Arrays <tt>discovery_order</tt> und <tt>finishing_order</tt> für den obigen Beispielgraphen gerade den vorher angeführten <tt>print</tt>-Ausgaben. Die Vorgänger im Array <tt>parents</tt> lauten: | |||

Knotennummer | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | |||

--------------+-----+-----+-----+-----+-----+-----+-----+----- | |||

Vorgänger | None| None| 1 | 4 | 2 | 2 | 3 | 3 | |||

Die Knotennummern dienen hier als Array-Indizes, und die dazugehörigen Arrayeinträge verweisen auf die Vorgänger. Man kann mit diesen Informationen den Weg von jedem Knoten zur Wurzel zurückverfolgen und damit den Tiefensuchbaum von unten nach oben rekonstruieren. Man beachte, dass <tt>parents</tt> den Eintrag <tt>None</tt> für die Knoten 0 umd 1 enthält, weil Knoten 0 in diesem Graphen nicht existiert und Knoten 1 als Wurzel der Suche keinen Vorgänger hat. | |||

Wird das Array <tt>parents</tt> verwendet, kann man den Code vereinfachen, indem man das Array <tt>visited</tt> einspart: Sobald ein Knoten erstmals besucht wurde, ist sein Vorgänger bekannt und damit ungleich <tt>None</tt>. Die Abfrage <tt>if parents[node] is None:</tt> liefert damit das gleiche Resultat wie die Abfrage <tt>if not visited[node]:</tt>. Einzige Ausnahme ist der Startknoten der Suche, dessen Vorgänger bisher <tt>None</tt> war. Dieses Problem löst man leicht mit der Konvention, dass man den Startknoten zu seinem eigenen Vorgänger erklärt. Man startet die Suche also mit <tt>visit(startnode, startnode)</tt> statt mit <tt>visit(startnode, None)</tt>. | |||

=== Breitensuche in Graphen (Breadth First Search, BFS) === | |||

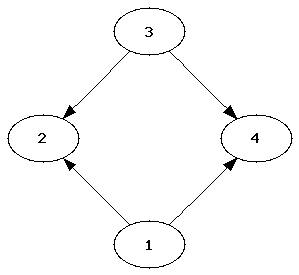

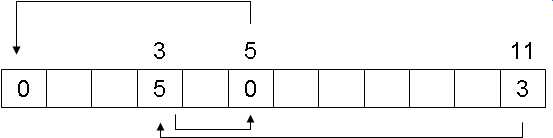

Im Gegensatz zur Tiefensuche werden bei der Breitensuche alle | Im Gegensatz zur Tiefensuche werden bei der Breitensuche alle Nachbarknoten abgearbeitet, <i>bevor</i> man rekursiv deren Nachbarn besucht. Man betrachtet somit zuerst alle Knoten, die den Abstand 1 von Startknoten haben, dann diejenigen mit dem Abstand 2 usw. Diese Reihenfolge bezeichnet man als <i>level-order</i>. Wir sind ihr beispielsweise in Übung 6 begegnet, als die ersten 7 Ebenen eines Treap ausgegeben werden sollten. Man implementiert Breitensuche zweckmäßig mit Hilfe einer Queue, die die Knoten in First In - First Out - Reihenfolge bearbeitet. Eine geeignete Datenstruktur hierfür ist die Klasse <tt>[http://docs.python.org/library/collections.html#collections.deque deque]</tt> aus dem Python-Modul <tt>[http://docs.python.org/library/collections.html collections]</tt> (eine Deque implementiert sowohl die Funktionalität einer Queue wie auch die eines Stacks, siehe Übung 3): | ||

from collections import deque | from collections import deque | ||

def bfs(graph, startnode) | def bfs(graph, startnode): | ||

parents = [None]*len(graph) # speichere für jeden Knoten den Vorgänger im Breitensuchbaum | |||

parents[startnode] = startnode # Konvention: der Startknoten hat sich selbst als Vorgänger | |||

q = deque() | q = deque() # Queue für die zu besuchenden Knoten | ||

q.append(startnode) | q.append(startnode) # Startknoten in die Queue einfügen | ||

while len(q) > 0: | while len(q) > 0: # solange noch Knoten zu bearbeiten sind | ||

node = q.popleft() | node = q.popleft() # Knoten aus der Queue nehmen (first in - first out) | ||

if | <font color=red> # Beachte: mit q.pop() bekommen wir DFS</font> | ||

print(node) # den Knoten bearbeiten (hier: Knotennummer drucken) | |||

for neighbor in graph[node]: # die Nachbarn expandieren | |||

if parents[neighbor] is None: # Nachbar wurde noch nicht besucht | |||

parents[neighbor] = node # => Vorgänger merken, Knoten dadurch als "besucht" markieren | |||

q.append(neighbor) # und in die Queue aufnehmen | |||

[[Image:Breitens.jpg]] | [[Image:Breitens.jpg]] | ||

Der Aufruf dieser Funktion liefert die Knoten ebenenweise, also zufällig genau in der Reihenfolge der Knotennummern: | Der Aufruf dieser Funktion liefert die Knoten des obigen Graphens ebenenweise, also zufällig genau in der Reihenfolge der Knotennummern: | ||

>>> bfs(graph, 1) | >>> bfs(graph, 1) | ||

1 | 1 | ||

| Line 441: | Line 482: | ||

7 | 7 | ||

Neben der ebenenweisen Ausgabe hat die Breitensuche viele weitere wichtige Anwendungen, z.B. beim Testen, ob ein gegebener Graph bi-partit ist (siehe [http://en.wikipedia.org/wiki/Breadth-first_search#Testing_bipartiteness WikiPedia]), sowie bei der Suche nach kürzesten Wegen (siehe unten) und kürzesten Zyklen. | |||

== Weitere Anwendungen der Tiefensuche == | |||

Die Tiefensuche hat zahlreiche Anwendungen, wobei der grundlegende Algorithmus immer wieder leicht modifiziert und an die jeweilige Aufgabe angepasst wird. Wir beschreiben im folgenden einige Beispiele. | |||

=== Test, ob ein ungerichteter Graph azyklisch ist === | |||

Ein zusammenhängender ungerichteter Graph ist azyklisch (also ein Baum) genau dann, wenn es nur einen möglichen Weg von jedem Knoten zu jedem anderen gibt. (Bei gerichteten Graphen sind die Verhältnisse komplizierter. Wir behandeln dies weiter unten.) Das kann man mittels Tiefensuche leicht feststellen: Die Kante, über die wir einen Knoten erstmals erreichen, ist eine <i>Baumkante</i> des Tiefensuchbaums. Erreichen wir einen bereits besuchten Knoten nochmals über eine andere Kante, haben wir einen Zyklus gefunden. Dabei müssen wir allerdings beachten, dass in einem ungerichteten Graphen jede Baumkante zweimal gefunden wird, einmal in Richtung vom Vater zum Kind und einmal in umgekehrter Richtung. Im zweiten Fall endet die Kante zwar in einem bereits besuchten Knoten (dem Vater), aber es entsteht dadurch kein Zyklus. Den Vaterknoten müssen wir deshalb überspringen, wenn wir über die Nachbarn iterieren: | |||

[[ | def undirected_cycle_test(graph): # Annahme: der Graph ist zusammenhängend | ||

# (andernfalls führe den Algorithmus für jede Zusammenhangskomponente aus) | |||

visited = [False]*len(graph) # Flags für bereits besuchte Knoten | |||

def visit(node, from_node): # rekursive Hilfsfunktion: gibt True zurück, wenn Zyklus gefunden wurde | |||

if not visited[node]: # wenn node noch nicht besucht wurde | |||

visited[node] = True # markiere node als besucht | |||

for neighbor in graph[node]: # besuche die Nachbarn ... | |||

if neighbor == from_node: # ... aber überspringe den Vaterknoten | |||

continue | |||

if visit(neighbor, node): # ... signalisiere, wenn rekursiv ein Zyklus gefunden wurde | |||

return True | |||

return False # kein Zyklus gefunden | |||

else: | |||

return True # Knoten schon besucht => Zyklus | |||

startnode = 0 # starte bei beliebigem Knoten (hier: Knoten 0) | |||

return visit(startnode, startnode) # gebe True zurück, wenn ein Zyklus gefunden wurde | |||

Wenn wir einen Zyklus finden, wird das weitere Traversieren das Graphen abgebrochen, denn ein Graph, der einmal zyklisch war, kann später nicht wieder azyklisch werden. Die notwendige Modifikation für unzusammenhängende Graphen erfolgt analog zum Algorithmus für die Detektion von Zusammenhangskomponenten, der im nächsten Abschnitt beschrieben wird. | |||

=== Damenproblem === | |||

Tiefensuche wird häufig verwendet, um systematisch nach der Lösung eines logischen Rätsels (oder allgemeiner nach der Lösung eines diskreten Optimierungsproblems) zu suchen. Besonders anschaulich hierfür ist das Damenproblem. Die Aufgabe besteht darin, <math>k</math> Damen auf einem Schachbrett der Größe <math>k \times k</math> so zu platzieren, dass sie sich (nach den üblichen Schach-Regeln) nicht gegenseitig schlagen können. Das folgende Diagramm zeigt eine Lösung für den Fall <math>k=4</math>. Die Positionen der Damen werden dabei wie üblich durch die Angabe der Spalte (Linie) mit Buchstaben und der Zeile (Reihe) mit Zahlen kodiert, hier also A2, B4, C1, D3: | |||

--------------- | |||

| | X | | | 4 | |||

|---|---|---|---| | |||

| | | | X | 3 | |||

|---|---|---|---| | |||

| X | | | | 2 | |||

|---|---|---|---| | |||

| | | X | | 1 | |||

--------------- | |||

A B C D | |||

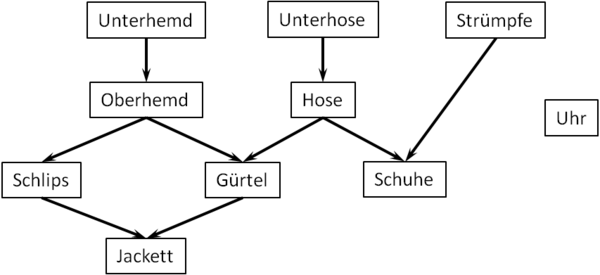

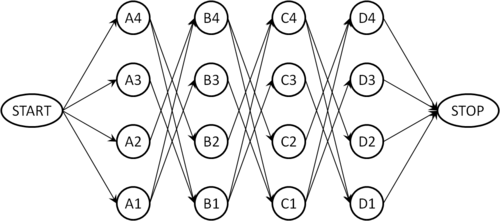

Um das Problem systematisch zu lösen, konstruieren wir einen gerichteten Graphen, dessen Knoten die möglichen Positionen der Damen kodieren. Wir verbinden Knoten, die zu benachbarten Linien gehören, genau dann mit einer Kante, wenn die zugehörigen Positionen kompatibel sind, also wenn sich die dort positionierten Damen nicht schlagen können. Der resultierende Graph für <math>k=4</math> hat folgende Gestalt: | |||

[[Image:damenproblem-graph.png|500px|center]] | |||

Knoten, die zur selben Reihe oder Linie gehören, sind beispielsweise nicht direkt verbunden, weil zwei Damen niemals in derselben Linie oder Reihe stehen dürfen. Um eine erlaubte Konfiguration zu finden, verwenden wir nun eine angepasste Version der Tiefensuche: Wir beginnen die Suche beim Knoten <tt>START</tt>. Sobald wir den Knoten <tt>STOP</tt> erreichen, beenden wir die Suche und lesen die Lösung am gerade gefundenen Weg von Start nach Stop ab. Zwei kleine Modifikationen des Grundalgorithmus stellen sicher, dass die Bedingungen der Aufgabe eingehalten werden: Wir dürfen bei der Tiefensuche nur dann zu einem Nachbarn weitergehen, wenn die betreffende Position mit allen im Pfad bereits gesetzten Positionen kompatibel ist, andernfalls ist diese Kante tabu. Landen wir aufgrund dieser Regel in einer Sackgasse (also in einem Knoten, wo keine der ausgehenden Kanten erlaubt ist), müssen wir zur nächsten erlaubten Abzweigung zurückgehen (Backtracking). Beim Zurückgehen müssen wir das <tt>parent</tt>-Flag wieder auf <tt>None</tt> zurücksetzen, weil der betreffende Knoten ja möglicherweise auf einem anderen erlaubten Weg erreichbar ist. | |||

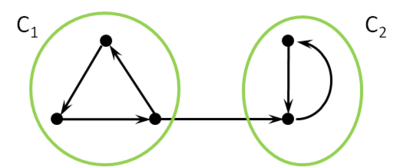

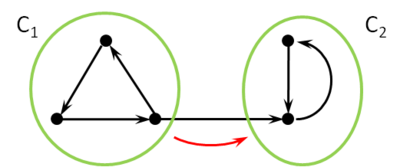

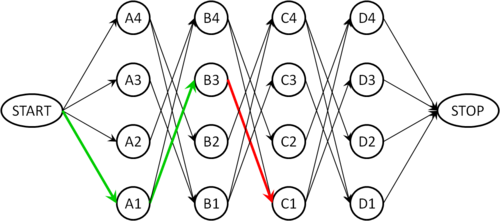

Der folgende Graph zeigt einen solchen Fall: Wir haben zwei Damen auf die Felder A1 und B3 positioniert (grüne Pfeile). Die einzig ausgehende Kante von B3 führt zum Knoten C1, welcher aber mit der Position A1 inkompatibel ist, so dass diese Kante nicht verwendet werden darf (roter Pfeil). Das Backtracking muss jetzt zu Knoten A1 zurückgehen (dabei wird das <tt>parent</tt>-Flag von B3 wieder auf <tt>None</tt> gesetzt), weil A1 mit der Kante nach B4 eine weitere Option hat, die geprüft werden muss (die allerdings hier auch nicht zum Ziel führt). | |||

[[Image:damenproblem-graph-failure.png|500px|center]] | |||

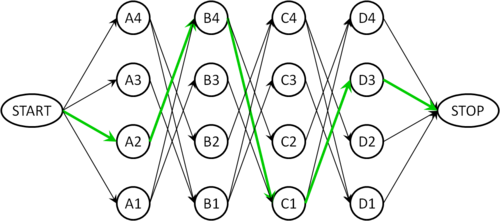

Nach einigen weiteren Sackgassen findet man schließlich den Pfad A2, B4, C1, D3, der im folgenden Graphen grün markiert ist und der obigen Lösung entspricht: | |||

[[Image:damenproblem-graph-success.png|500px|center]] | |||

=== Finden von Zusammenhangskomponenten === | |||

Das Auffinden und Markieren von Zusammenhangskomponenten (also maximalen zusammenhängenden Teilgraphen) ist eine grundlegende Aufgabe in ungerichteten, unzusammenhängenden Graphen (bei gerichteten Graphen sind die Verhältnisse wiederum komplizierter, siehe unten). Zwei Knoten u und v gehören zur selben Zusammenhangskomponente genau dann, wenn es einen Pfad von u nach v gibt (da der Graph ungerichtet ist, gibt es dann auch einen Pfad von v nach u). Man sagt auch, dass "v von u aus erreichbar" ist. Unzusammenhängende Graphen entstehen in der Praxis häufig, wenn die Kanten gewisse Relationen zwischen den Knoten kodieren: | |||

* Wenn die Knoten Städte sind und die Kanten Straßen, sind diejenigen Städte in einer Zusammenhangskomponente, die per Auto von einander erreichbar sind. Unzusammenhängende Graphen entstehen hier beispielsweise, wenn eine Insel nicht durch eine Brücke erschlossen ist, wenn Grenzen gesperrt sind oder wenn ein Gebirge zu unwegsam ist, um Straßen zu bauen. | |||

* Wenn Knoten Personen sind, und Kanten die Eltern-Kind-Relation beschreiben, so umfasst jede Zusammenhangskomponenten die Verwandten (auch wenn sie nur über viele "Ecken" verwandt sind). | |||

* In der Bildverarbeitung entsprechen Knoten den Pixeln, und dieselben werden durch eine Kante verbunden, wenn sie zum selben Objekt gehören. Die Zusammenhangskomponenten entsprechen somit den Objekten im Bild (siehe Übungsaufgabe). | |||

Die Zusammenhangskomponenten bilden eine Äquivalenzrelation. Folglich kann für jede Komponente ein Reprässentant bestimmt werden, der sogenannte "Anker". Kennt jeder Knoten seinen Anker, ist das Problem der Zusammenhangskomponenten gelöst. | |||

==== Lösung mittels Tiefensuche ==== | |||

Unser erster Ansatz ist, den Anker mit Hilfe der Tiefensuche zu finden. Anstelle der property map <tt>visited</tt> verwenden wir diesmal eine property map <tt>anchors</tt>, die für jeden Knoten die Knotennummer des zugehörigen Ankers angibt, oder <tt>None</tt>, wenn der Knoten noch nicht besucht wurde. Dabei verwenden wir wieder die Konvention, dass Anker auf sich selbst zeigen. Für viele Anwendungen ist es außerdem (oder stattdessen) zweckmäßig, die Zusammenhangskomponenten mit einer laufenden Nummer, einem sogenannten <i>Label</i>, durchzuzählen. Dann kann man zusätzliche Informationen zu jeder Komponente (beispielsweise deren Größe) einfach in einem Array speichern, das über die Labels indexiert wird. Die folgende Version der Tiefensuche bestimmt sowohl die Anker als auch die Labels für jeden Knoten: | |||

Unser erster Ansatz ist, den Anker mit Hilfe der Tiefensuche zu finden, | |||

def connectedComponents(graph): | def connectedComponents(graph): | ||

def visit( | anchors = [None] * len(graph) # property map für Anker jedes Knotens | ||

labels = [None] * len(graph) # property map für Label jedes Knotens | |||

def visit(node, anchor): | |||

if anchors[node] is | """anchor ist der Anker der aktuellen ZK""" | ||

if anchors[node] is None: # wenn node noch nicht besucht wurde: | |||

anchors[node] = anchor # setze seinen Anker | |||

visit( | labels[node] = labels[anchor] # und sein Label | ||

for neighbor in graph[node]: # und besuche die Nachbarn | |||

visit(neighbor, anchor) | |||

current_label = 0 # Zählung der ZK beginnt bei 0 | |||

for node in range(len(graph)): | for node in range(len(graph)): | ||

visit( | if anchors[node] is None: # Anker noch nicht bekannt => neue ZK gefunden | ||

return anchors | labels[node] = current_label # Label des Ankers setzen | ||

visit(node, node) # Knoten der neuen ZK rekursiv suchen | |||

current_label += 1 # Label für die nächste ZK hochzählen | |||

return anchors, labels | |||

Interessant ist hier die Schleife über alle Knoten des Graphen am Ende des Algorithmus, die bei den bisherigen Versionen der Tiefensuche nicht vorhanden war. Um ihre Funktionsweise zu verstehen, nehmen wir für den Moment an, dass der Graph zusammenhängend ist. Dann findet diese Schleife den ersten Knoten des Graphen und führt die Tiefensuche mit diesem Knoten als Startknoten aus. Sobald die Rekursion zurückkehrt, sind alle Knoten des Graphen besucht (weil der Graph ja zusammenhängend war), so dass die Schleife alle weiteren Knoten überspringt (die if-Anweisung liefert für keinen weiteren Knoten True). Bei unzusammenhängenden Graphen dagegen erreicht die Tiefensuche nur die Knoten derselben Komponente, die im weiteren Verlauf der Schleife übersprungen werden. Findet die if-Anweisung jetzt einen noch nicht besuchten Knoten, muss dieser folglich in einer neuen Komponente liegen. Wir verwenden diesen Knoten als Anker und bestimmen die übrigen Knoten dieser Komponente wiederum mit Tiefensuche. | |||

* Beispiel: ... | * Beispiel: ... <b> under construction </b> | ||

Man erkennt, dass die Tiefensuche nach dem <i>Anlagerungsprinzip</i> vorgeht: Beginnend vom einem Startknoten (dem Anker) werden die Knoten der aktuellen Komponente nach und nach an den Tiefensuchbaum angehangen. Erst, wenn nichts mehr angelagert werden kann, geht der Algorithmus zur nächsten Komponente über. | |||

==== Lösung mittels Union-Find-Algorithmus ==== | |||

Im Gegensatz zum Anlagerungsprinzip sucht der Union-Find-Algorithmus die Zusammenhangskomponenten mit dem <i>Verschmelzungsprinzip</i>: Eingangs wird jeder Knoten als ein Teilgraph für sich betrachtet. Dann iteriert man über alle Kanten und verbindet deren Endknoten jeweils zu einem gemeinsamen Teilgraphen (falls die beiden Enden einer Kante bereits im selben Teilgraphen liegen, wird diese Kante ignoriert). Solange noch Kanten vorhanden sind, werden dadurch immer wieder Teilgraphen in größere Teilgraphen verschmolzen. Am Ende bleiben die maximalen zusammenhängenden Teilgraphen (also gerade die Zusammenhangskomponenten) übrig. Dieser Algorithmus kommt ohne Tiefensuche aus und ist daher in der Praxis oft schneller, allerdings auch etwas komplizierter zu implementieren. | |||

Der Schlüssel des Algorithmus ist eine Funktion <tt>findAnchor()</tt>, die zu jedem Knoten den aktuellen Anker sucht. Der Anker existiert immer, da jeder Knoten von Anfang an zu einem Teilgraphen gehört (anfangs ist jeder Teilgraph trivial und besteht nur aus dem Knoten selbst). Die Verschmelzung wird realisiert, indem der Anker des einen Teilgraphen seine Rolle verliert und stattdessen der Anker des anderen Teilgraphen eingesetzt wird. | |||

Zur Verwaltung der Anker verwenden wir wieder eine property map <tt>anchors</tt> mit der Konvention, dass die Anker auf sich selbst verweisen. Es wäre jedoch zu teuer, wenn man bei jeder Verschmelzung alle Anker-Einträge der beteiligten Knoten aktualisieren müsste, da jeder Knoten im Laufe des Algorithmus mehrmals seinen Anker wechseln kann. Statt dessen definiert man Anker rekursiv: Verweist ein Knoten auf einen Anker, der mittlerweile diese Rolle verloren hat, folgt man dem Verweis von diesem Knoten (dem ehemaligen Anker) weiter, bis man einen tatsächlichen Anker gefunden hat - erkennbar daran, dass er auf sich selbst verweist. Diese Suchfunktion kann folgendermassen implementiert werden: | |||

def findAnchor(anchors, node): | |||

while node != anchors[node]: # wenn node kein Anker ist | |||

node = anchors[node] # ... verfolge die Ankerkette weiter | |||

return node | |||

Allerdings kann diese Kette im Laufe vieler Verschmelzungen sehr lang werden, so dass das Verfolgen der Kette teuer wird. Man vermeidet dies durch die sogenannte <i>Pfadkompression</i>: Immer, wenn man den Anker gefunden hat, aktualisiert man den Eintrag am Anfang der Kette. Die Funktion <tt>findAnchor()</tt> wird dadurch nur wenig komplizierter: | |||

def findAnchor(anchors, node): | |||

start = node # wir merken uns den Anfang der Kette | |||

while node != anchors[node]: # wenn node kein Anker ist | |||

node = anchors[node] # ... verfolge die Ankerkette weiter | |||

anchors[start] = node # Pfadkompression: aktualisiere den Eintrag am Anfang der Kette | |||

return node | |||

Man kann zeigen, dass die Ankersuche mit Pfadkompression zu einer fast konstanten amortisierten Laufzeit pro Aufruf führt. | |||

Um mit jeder Kante des (ungerichteten) Graphen nur maximal einmal eine Verschmelzung durchzuführen, betrachten wir jede Kante nur in der Richtung von der kleineren zur größeren Knotennummer, die umgekehrte Richtung wird ignoriert. Außerdem ist es zweckmäßig, bei jeder Verschmelzung denjenigen Anker mit der kleineren Knotennummer als neuen Anker zu übernehmen. Dann gilt für jede Zusammenhangskomponente, dass gerade der Knoten mit der kleinsten Knotennummer der Anker ist (genau wie bei der Lösung mittels Tiefensuche), was die weitere Analyse vereinfacht, z.B. die Zuordnung der Labels zu den Komponenten am Ende des Algorithmus. | |||

def unionFindConnectedComponents(graph): | |||

= | anchors = list(range(len(graph))) # Initialisierung der property map: jeder Knoten ist sein eigener Anker | ||

for node in range(len(graph)): # iteriere über alle Knoten | |||

for neighbor in graph[node]: # ... und über deren ausgehende Kanten | |||

if neighbor < node: # ignoriere Kanten, die in falscher Richtung verlaufen | |||

continue | continue | ||

if | # hier landen wir für jede Kante des Graphen genau einmal | ||

a1 = findAnchor(anchors, node) # finde Anker ... | |||

return | a2 = findAnchor(anchors, neighbor) # ... der beiden Endknoten | ||

if a1 < a2: # Verschmelze die beiden Teilgraphen | |||

anchors[a2] = a1 # (verwende den kleineren der beiden Anker als Anker des | |||

elif a2 < a1: # entstehenden Teilgraphen. Falls node und neighbor | |||

anchors[a1] = a2 # den gleichen Anker haben, waren sie bereits im gleichen | |||

# Teilgraphen, und es passiert hier nichts.) | |||

# Bestimme jetzt noch die Labels der Komponenten | |||

labels = [None]*len(graph) # Initialisierung der property map für Labels | |||

current_label = 0 # die Zählung beginnt bei 0 | |||

for node in range(len(graph)): | |||

a = findAnchor(anchors, node) # wegen der Pfadkompression zeigt jeder Knoten jetzt direkt auf seinen Anker | |||

if a == node: # node ist ein Anker | |||

labels[a] = current_label # => beginne eine neue Komponente | |||

current_label += 1 # und zähle Label für die nächste ZK hoch | |||

else: | |||

labels[node] = labels[a] # node ist kein Anker => setzte das Label des Ankers | |||

# (wir wissen, dass labels[a] bereits gesetzt ist, weil | |||

# der Anker immer der Knoten mit der kleinsten Nummer ist) | |||

return anchors, labels | |||

* Beispiel: ... <b>under construction</b> | |||

== Kürzeste Wege (Pfade) == | |||

Eine weitere grundlegende Aufgabe in Graphen ist die Bestimmung eines kürzesten Weges zwischen zwei gegebenen Knoten. Dies hat offensichtliche Anwendungen bei Routenplanern und Navigationssystemen und ist darüber hinaus wichtiger Bestandteil anderer Algorithmen, z.B. bei der Berechnung eines maximalen Flusses mit der [http://en.wikipedia.org/wiki/Edmonds%E2%80%93Karp_algorithm Methode von Edmonds und Karp]. | |||

=== Kürzeste Wege | === Kürzeste Wege in ungewichteten Graphen mittels Breitensuche === | ||

Im Fall eines ungewichteten Graphen ist die Länge eines Weges einfach durch die Anzahl der durchlaufenen Kanten definiert. Daraus folgt, dass kürzeste Pfade mit einer leicht angepassten Version der Breitensuche gefunden werden können: Aufgrund des first in-first out-Verhaltens der Queue betrachtet die Breitensuche alle (erreichbaren) Knoten in der Reihenfolge ihres Abstandes vom Startknoten. Wenn wir den Zielknoten zum ersten Mal erreichen, und der gerade gefundene Weg vom Start zum Ziel hat die Länge L, muss dies der kürzeste Weg sein: Alle möglichen Wege der Länge L' < L hat die Breitensuche ja bereits betrachtet, ohne dass dabei der Zielknoten erreicht wurde. Daraus folgt übrigens eine allgemeine Eigenschaft aller Algorithmen für kürzeste Wege: Wenn der kürzeste Weg vom Start zum Ziel die Länge L hat, finden diese Algorithmen als Nebenprodukt auch die kürzesten Wege zu allen Knoten, für die L' < L gilt. | |||

Um den Algorithmus zu implementieren, passen wir die Breitensuche so an, dass anstelle der property map <tt>visited</tt> eine property map <tt>parents</tt> verwendet wird, die für jeden besuchten Knoten den Vaterknoten im Breitensuchbaum speichert. Durch Rückverfolgen der <tt>parent</tt>-Kette können wir den Pfad vom Ziel zum Start rekonstruieren, und durch Umdrehen der Reihenfolge erhalten wir den gesuchten Pfad vom Start zum Ziel. Sobald der Zielknoten erreicht wurde, können wir die Breitensuche abbrechen (<tt>break</tt>-Befehl in der ersten <tt>while</tt>-Schleife). Falls der gegebene Graph unzusammenhängend ist, kann es passieren, dass gar kein Weg gefunden wird, weil Start und Ziel in verschiedenen Zusammenhangskomponenten liegen. Dies erkennen wir daran, dass die Breitensuche beendet wurde, ohne den Zielknoten zu besuchen. Dann gibt die Funktion statt eines Pfades dern Wert <tt>None</tt> zurück: | |||

from collections import deque | |||

def shortestPath(graph, startnode, destination): | |||

parents = [None]*len(graph) # Registriere für jeden Knoten den Vaterknoten im Breitensuchbaum | |||

parents[startnode] = startnode # startnode ist die Wurzel des Baums => verweist auf sich selbst | |||

q = deque() # Queue für die zu besuchenden Knoten | |||

q.append(startnode) # Startknoten in die Queue einfügen | |||

while len(q) > 0: # Solange es noch unbesuchte Knoten gibt | |||

node = q.popleft() # Knoten aus der Queue nehmen (first in - first out) | |||

if node == destination: # Zielknoten erreicht | |||

break # => Suche beenden | |||

for neighbor in graph[node]: # Besuche die Nachbarn von node | |||

if parents[neighbor] is None: # aber nur, wenn sie noch nicht besucht wurden | |||

parents[neighbor] = node # setze node als Vaterknoten | |||

q.append(neighbor) # und füge neighbor in die Queue ein | |||

if parents[destination] is None: # Breitensuche wurde beendet ohne den Zielknoten zu besuchen | |||

return None # => kein Pfad gefunden (unzusammenhängender Graph) | |||

# Pfad durch die parents-Kette zurückverfolgen und speichern | |||

path = [destination] | |||

while path[-1] != startnode: | |||

path.append(parents[path[-1]]) | |||

path.reverse() # Reihenfolge umdrehen (Ziel => Start wird zu Start => Ziel) | |||

return path # gefundenen Pfad zurückgeben | |||

=== Gewichtete Graphen === | |||

Das Problem der Suche nach kürzesten Wegen wird wesentlich interessanter und realistischer, wenn wir zu gewichteten Graphen übergehen: | |||

; Definition - kantengewichteter Graph | |||

: Jeder Kante (s,t) des Graphen ist eine reelle oder natürliche Zahl w<sub>st</sub> zugeordnet, die üblicherweise als ''Kantengewicht'' bezeichnet wird. | |||

; Definition - knotengewichteter Graph | |||

: Jedem Knoten v des Graphen ist eine reelle oder natürliche Zahl w<sub>v</sub> zugeordnet, die üblicherweise als ''Knotengewicht'' bezeichnet wird. | |||

* | Je nach Anwendung benötigt man Knoten- oder Kantengewichte oder auch beides zugleich. Wir beschränken uns in der Vorlesung auf kantengewichtete Graphen. Beispiele für die Informationen, die man durch Kantengewichte ausdrücken kann, sind | ||

* wenn die Knoten Orte sind: Abstand von Anfangs- und Endknoten jeder Kante (z.B. Luftline oder Straßenentfernung), Fahrzeit zwischen den Orten | |||

* wenn der Knoten ein Rohrnetzwerk beschreibt: Durchflusskapazität der einzelnen Rohre (für max-Flussprobleme), analog bei elektrischen Netzwerken: elektrischer Widerstand | |||

* wenn die Knoten Währungen repräsentieren, können deren Wechselkurse durch Kantengewichte angegeben werden. | |||

Bei einigen Beispielen ergeben sich unterschiedliche Kantengewichte, wenn eine Kante von s nach t anstatt von t nach s durchlaufen wird. Beispielsweise können sich die Fahrzeiten erheblich unterscheiden, wenn es in einer Richtung bergauf, in der anderen bergab geht, obwohl die Entfernung in beiden Fällen gleich ist. Hier ergibt sich natürlicherweise ein gerichteter Graph. In anderen Beispielen (z.B. bei Luftlinienentfernungen, in guter Näherung auch bei Straßenentfernungen) sind die Gewichte von der Richtung unabhängig, so dass wir ungerichtete Graphen verwenden können. | |||

Die Repräsentation der Kantengewichte im Programm richtet sich nach der Repräsentation des Graphen selbst. Am einfachsten ist wiederum die Adjazenzmatrix, die aber nur für dichte Graphen (<math>E = O(V^2)</math>, mit E als Anzahl der Kanten und V als Anzahl der Knoten) effizient ist. Bei gewichteten Graphen gibt das Matrixelement a<sub>ij</sub> das Gewicht der Kante i ⇒ j (wobei a<sub>ij</sub> = 0 gesetzt wird, wenn diese Kante nicht existiert). Wie zuvor gilt für ungerichtete Graphen a<sub>ij</sub> = a<sub>ji</sub> (symmetrische Matrix), während dies für gerichtete Graphen nicht gelten muss. | |||

Bei Graphen in Adjazenzlistendarstellung hat es sich bewährt, die Gewichte in einer <i>property map</i> zu speichern. Weiter oben haben wir bereits property maps für Knoteneigenschaften (z.B. <tt>visited</tt> und <tt>anchors</tt>) gesehen. Property maps für Kanten funktionieren ganz analog, allerdings muss man jetzt Paare von Knoten (nämlich Anfangs- und Endknoten der Kante) als Schlüssel verwenden und die Daten entsprechend in einem assoziativen Array ablegen: | |||

w = weights[(i,j)] # Zugriff auf das Gewicht der Kante i ⇒ j | |||

Alternativ könnte man auch die Graph-Datenstruktur selbst erweitern, aber dies ist weniger zu empfehlen, weil jeder Algorithmus andere Erwiterungen benötigt und damit die Datenstruktur sehr unübersichtlich würde. | |||

und der Weg | Der kürzeste Weg ist nun definiert als der Weg, bei dem die Summe der Kantengewichte minimal ist: | ||

;Definition - Problem des kürzesten Weges | |||

: Sei P die Menge aller Wege von u nach v, und <math>p \in P</math> einer dieser Wege. Wenn der Grpah einfach ist (es also keine Mehrfachkanten zwischen denselben Knoten und keine Schleifen gibt), ist der Weg p durch die Folge der besuchten Knoten eindeutig bestimmt: | |||

: <math>p : \ \ u = x_0 \rightarrow x_1 \rightarrow x_2 \rightarrow ... \rightarrow v = x_{n_p}</math> | |||

:wo <math>n_p</math> die Anzahl der Kanten im Weg p ist. Seine Kosten W<sub>p</sub> ergeben sich als Summer der Gewichte der einzelnen Kanten | |||

: <math>W_p = \sum_{k=1}^{n_p} w_{x_{k-1}x_k}</math> | |||

: und ein kürzester Weg <math>p^* \in P</math> ist ein Weg mit minimalen Kosten | |||

: <math>p^* = \textrm{argmin}_{p\in P}\ \ W_p</math> | |||

: Das Problem des kürzesten Weges besteht darin, einen optimalen Weg <i>p*</i> zwischen gegebenen Knoten u und v zu finden. | |||

Die Lösung dieses Problems hängt davon ab, ob alle Kantengewichte positiv sind, oder ob es auch negative Kantengewichte gibt. In letzeren Fall ist es möglich, durch eine Verlängerung des Weges die Kosten zu redizieren, während sich im ersteren Fall die Kosten immer erhöhen, wenn man den Weg verlängert. | |||

Negative Gewichte treten z.B. bei den Währungsgraphen auf. Auf den ersten Blick entsprechen diese Graphen nicht den Anforderungen an das Problem des kürzesten Weges, weil Wechselkurse miteinander (und mit Geldbeträgen) multipliziert anstatt addiert werden. Man beseitigt diese Schwierigkeit aber leicht, indem man die <i>Logarithmen</i> der Wechselkurse als Kantengewichte verwendet, wodurch sich die Multiplikation in eine Addition der Logarithmen verwandelt. Wechselkurse < 1 führen nun zu negativen Gewichten. | |||

dann | Interessant werden negative Gewichte vor allem in Graphen mit Zyklen. Dann kann es nämlich passieren, dass die Gesamtkosten eines Zyklus ebenfalls negativ sind. Jeder Weg, der den Zyklus enthält, hat dann Kosten von <math>-\infty</math>, weil man den Zyklus beliebig oft durchlaufen und dadurch die Gesamtkosten immer weiter verkleinern kann: | ||

Kosten | /\ 1. Durchlauf: Kosten -1 | ||

1 / \ -4 2. Durchlauf: Kosten -2 | |||

/____\ etc. | |||

2 | |||

Um hier nicht in einer Endlosschleife zu landen, benötigt man spezielle Algorithmen, die mit dieser Situation umgehen können. Der [http://de.wikipedia.org/wiki/Bellman-Ford-Algorithmus Algorithmus von Bellmann und Ford] beispielsweise bricht die Suche nach dem kürzesten Weg ab, sobald er einen negativen Zyklus entdeckt, aber andernfalls kann er negative Gewichte problemlos verarbeiten. | |||

Die Detektion negativer Zyklen hat wiederum eine interessante Anwendung bei Währungsgraphen: Ein Zyklus bedeutet hier, dass man Geld über mehrere Stufen von einer Währung in die nächste und am Schluß wieder in die Originalwährung umtauscht, und ein negativer Zyklus führt dazu, dass man am Ende <i>mehr</i> Geld besitzt als am Anfang (damit negative Zyklen wirklich einen Gewinn bedeuten und keinen Verlust, müssen die Wechselkurse vor der Logarithmierung in [http://de.wikipedia.org/wiki/Wechselkurs#Nominaler_Wechselkurs Preisnotierung] angegeben sein). Bei Privatpersonen ist dies ausgeschlossen, weil die Umtauschgebühren den möglichen Gewinn mehr als aufzehren. Banken mit direktem weltweitem Börsenzugang hingegen unternehmen große Anstrengungen, um solche negativen Zyklen möglichst schnell (nämlich vor der Konkurrenz) zu entdecken und auszunutzen. Diese Geschäftsmethode bezeichnet man als [http://de.wikipedia.org/wiki/Arbitrage Arbitrage] und die Existenz eines negativen Zyklus als Arbitragegelegenheit. Durch die Kursschwankungen (und durch die ausgleichende Wirkung der Arbitragegeschäfte selbst) existieren die Arbitragegelegenheiten nur für kurze Zeit, und ihre Detektion erfordert leistungsfähige Echtzeitalgorithmen. | |||

In dieser Vorlesung beschränken wir uns hingegen auf Graphen mit ausschließlich positiven Gewichten. In diesem Fall ist der Algorithmus von Dijkstra die Methode der Wahl, weil er wesentlich schneller arbeitet als der Bellmann-Ford-Algorithmus. | |||

=== Algorithmus von Dijkstra === | === Algorithmus von Dijkstra === | ||

| Line 659: | Line 729: | ||

ges. 06. August 2002 | ges. 06. August 2002 | ||

Dijkstra war ein niederländischer Informatiker und Wegbereiter der strukturierten Programmierung. 1972 erhielt er für seine Leistung in der Technik und Kunst der Programmiersprachen den Turing Award, der jährlich von der Association for Computing Machinery (ACM) an Personen verliehen wird, die sich besonders um die Entwicklung der Informatik verdient gemacht haben. Zu seinen Beiträgen zur Informatik gehören unter anderem der Dijkstra-Algorithmus zur Berechnung des kürzesten Weges in einem Graphen sowie eine Abhandlung über den go-to-Befehl und warum er nicht benutzt werden sollte. Der go-to-Befehl war in den 60er und 70er Jahren weit verbreitet, führte aber zu Spaghetti-Code. In seinem berühmten Paper "A Case against the GO TO Statement"[http://www.cs.utexas.edu/users/EWD/ewd02xx/EWD215.PDF], das als Brief mit dem Titel "Go-to statement considered harmful" veröffentlicht wurde, argumentiert Dijkstra, dass es umso schwieriger ist, dem Quellcode eines Programmes zu folgen, je mehr go-to-Befehle darin enthalten sind und zeigt, dass man auch ohne diesen Befehl gute Programme schreiben kann. | Dijkstra war ein niederländischer Informatiker und Wegbereiter der strukturierten Programmierung. 1972 erhielt er für seine Leistung in der Technik und Kunst der Programmiersprachen den Turing Award, der jährlich von der Association for Computing Machinery (ACM) an Personen verliehen wird, die sich besonders um die Entwicklung der Informatik verdient gemacht haben. Zu seinen Beiträgen zur Informatik gehören unter anderem der Dijkstra-Algorithmus zur Berechnung des kürzesten Weges in einem Graphen sowie eine Abhandlung über den go-to-Befehl und warum er nicht benutzt werden sollte. Der go-to-Befehl war in den 60er und 70er Jahren weit verbreitet, führte aber zu Spaghetti-Code. In seinem berühmten Paper "A Case against the GO TO Statement"[http://www.cs.utexas.edu/users/EWD/ewd02xx/EWD215.PDF], das als Brief mit dem Titel "Go-to statement considered harmful" veröffentlicht wurde, argumentiert Dijkstra, dass es umso schwieriger ist, dem Quellcode eines Programmes zu folgen, je mehr go-to-Befehle darin enthalten sind und zeigt, dass man auch ohne diesen Befehl gute Programme schreiben kann. | ||

==== Algorithmus ==== | ==== Algorithmus ==== | ||

Der Dijkstra-Algorithmus für kürzeste Wege ist dem oben vorgestellten Algorithmus <tt>shortestPath()</tt> auf der Basis von Breitensuche sehr ähnlich. Insbesondere gilt auch hier, dass neben dem kürzesten Weg vom Start zum Ziel auch alle kürzesten Wege gefunden werden, deren Endknoten dem Start näher sind als der Zielknoten. Aufgrund der Kantengewichte gibt es aber einen wichtigen Unterschied: Der erste gefundene Weg zu einem Knoten ist nicht mehr notwendigerweise der kürzeste. Wir bestimmen deshalb für jeden Knoten mehrere Kandidatenwege und verwenden eine Prioritätswarteschlange (statt einer einfachen First in - First out - Queue), um diese Wege nach ihrer Länge zu sortieren. Die Kandidatenwege für einen gegebenen Knoten werden unterschieden, indem wir auch den Vorgängerknoten im jeweiligen Weg speichern. Wenn ein Knoten <i>erstmals</i> an die Spitze der Prioritätswarteschlange gelangt, haben wir den kürzesten Weg zu diesem Knoten gefunden (das wird weiter unten formal bewiesen), und der Vorgänger des Knotens in diesem Weg wird zu seinem Vaterknoten. Erscheint derselbe Knoten später nochmals an der Spitze der Prioritätswarteschlange, handelt es sich um einen Kandidatenweg, der sich nicht als kürzester erwiesen hat und deshalb ignoriert werden kann. Wir erkennen dies leicht daran, dass der Vaterknoten in der property map <tt>parents</tt> bereits gesetzt ist. | |||

Eine geeignete Datenstruktur für die Prioritätswarteschlange wird durch das Python-Modul [http://docs.python.org/library/heapq.html heapq] realisiert. Es verwendet ein normales Pythonarray als unterliegende Repräsentation für einen Heap und stellt effiziente <tt>heappush</tt> und <tt>heappop</tt>-Funktionen zur Verfügung. Dies entspricht genau unserer Vorgehensweise im Kapitel [[Prioritätswarteschlangen]]. Als Datenelement erwartet die Funktion <tt>heappush</tt> ein Tupel, dessen erstes Element die Priorität sein muss. Die übrigen Elemente des Tupels (und damit auch deren Anzahl) können je nach Anwendung frei festgelegt werden. Wir legen fest, dass das zweite Element den Endknoten des betrachteten Weges und das dritte den Vorgängerknoten speichert. | |||

Die Kantengewichte werden dem Algorithmus in der property map <tt>weights</tt> übergeben: | |||

<code python> | |||

import heapq # heapq implementiert die Funktionen für Heaps | |||

def dijkstra(graph, weights, startnode, destination): | |||

parents = [None]*len(graph) # registriere für jeden Knoten den Vaterknoten im Pfadbaum | |||

q = [] # Array q wird als Heap verwendet | |||

<font color=red>heapq.heappush(q, (0.0, startnode, startnode))</font> # Startknoten in Heap einfügen | |||

while len(q) > 0: # solange es noch Knoten im Heap gibt: | |||

<font color=red>length, node, predecessor = heapq.heappop(q)</font> # Knoten aus dem Heap nehmen | |||

<font color=red>if parents[node] is not None:</font> # parent ist schon gesetzt => es gab einen anderen, kürzeren Weg | |||

<font color=red>continue</font> # => wir können diesen Weg ignorieren | |||

<font color=red>parents[node] = predecessor</font> # parent setzen | |||

if node == destination: # Zielknoten erreicht | |||

break # => Suche beenden | |||

for neighbor in graph[node]: # die Nachbarn von node besuchen, | |||

if parents[neighbor] is None: # aber nur, wenn ihr kürzester Weg noch nicht bekannt ist | |||

<font color=red>newLength = length + weights[(node,neighbor)]</font> # berechne Pfadlänge zu neighbor | |||

<font color=red>heapq.heappush(q, (newLength, neighbor, node))</font> # und füge neighbor in den Heap ein | |||

if parents[destination] is None: # Suche wurde beendet ohne den Zielknoten zu besuchen | |||

return None, None # => kein Pfad gefunden (unzusammenhängender Graph) | |||

# Pfad durch die parents-Kette zurückverfolgen und speichern | |||

path = [destination] | |||

while path[-1] != startnode: | |||

path.append(parents[path[-1]]) | |||

path.reverse() # Reihenfolge umdrehen (Ziel => Start wird zu Start => Ziel) | |||

return path, length # gefundenen Pfad und dessen Länge zurückgeben | |||

</code> | |||

Die wesentlichen Unterschiede zur Breitensuche sind im Code rot markiert: Anstelle der Queue verwenden wir jetzt einen Heap, und der Startknoten wird mit Pfadlänge 0 als erstes eingefügt. In der Schleife <tt>while len(q) > 0:</tt> wird jeweils der Knoten <tt>node</tt> mit der aktuell kürzesten Pfadlänge aus dem Heap entfernt. Die Pfadlänge vom Start zu diesem Knoten wird in der Variable <tt>length</tt> gespeichert, sein Vorgänger in der Variable <tt>predecessor</tt>. Wenn der aktuelle Weg nicht der kürzeste ist (<tt>parents[node]</tt> war bereits gesetzt), wird dieser Weg ignoriert. Andernfalls werden die property map <tt>parents</tt> aktualisiert und die Nachbarn von <tt>node</tt> besucht. Beim Scannen der Nachbarn berechnen wir zunächst die Länge <tt>newLength</tt> das Weges <tt>startnode => node => neighbor</tt> als Summe von <tt>length</tt> und dem Gewicht der Kante <tt>(node, neighbode)</tt>. Diese Länge wird beim Einfügen des Nachbarknotens in den Heap zur Priorität des aktuellen Weges. | |||

Die wichtigsten Prinzipien des Dijkstra-Algorithmus noch einmal im Überblick: | |||

* Der Dijkstra-Algorithmus ist Breitensuche mit Prioritätswarteschlange (Heap) statt einer einfache Warteschlange (Queue). | |||

* Die Prioritätswarteschlange speichert alle Wege, die bereits gefunden worden sind und ordnet sie aufsteigend nach ihrer Länge. | |||

* Das Sortieren (und damit der ganze Algorithmus) funktioniert nur mit positiven Kantengewichten korrekt. | |||

* Da ein Knoten auf mehreren Wegen erreichbar sein kann, kann er auch mehrmals im Heap sein. | |||

* Wenn ein Knoten <i>erstmals</i> aus der Prioritätswarteschlange entnommen wird, ist der gefundene Weg der kürzeste zu diesem Knoten. Andernfalls wird der Weg ignoriert. | |||

* Wenn der Knoten <tt>destination</tt> aus dem Heap entnommen wird, ist der kürzeste Weg von Start nach Ziel gefunden, und die Suche kann beendet werden. | |||

In unserer Implementation können, wie gesagt, mehrere Wege zum selben Knoten gleichzeitig in der Prioritätswarteschlange sein. Im Prinzip wäre es auch möglich, immer nur den besten zur Zeit bekannten Weg zu jedem Enknoten in der Prioritätswarteschlange zu halten - sobald ein besserer Kandidat gefunden wird, ersetzt er den bisherigen Kandidaten, anstatt zusätzlich eingefügt zu werden. Dies erfordert aber eine wesentlich kompliziertere Prioritätswarteschlange, die eine effiziente <tt>updatePriority</tt>-Funktion anbietet, ohne dass dadurch eine signifikante Beschleunigung erreicht wird. Deshalb verfolgen wir diesen Ansatz nicht. | |||

==== Beispiel ==== | ==== Beispiel ==== | ||

<b>under construction</b> | |||

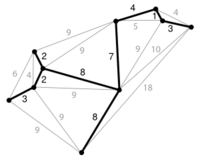

[[Image:Bsp.jpg]] | [[Image:Bsp.jpg]] | ||

==== Komplexität von Dijkstra ==== | |||

Zur Analyse der Komplexität nehmen wir an, dass der Graph V Knoten und E Kanten hat. Die Initialisierung der property map <tt>parents</tt> am Anfang der Funktion hat offensichtlich Komplexität O(V), weil Speicher für V Knoten allokiert wird. Der Code am Ende der Funktion, der aus der property map <tt>parents</tt> den Pfad extrahiert, hat ebenfalls die Komplexität O(V), weil der Pfad im ungünstigen Fall sämtliche Knoten des Graphen umfasst. Beides wird durch die Komplexität der Hauptschleife dominiert, zu deren Analyse wir den folgenden Codeausschnitt genauer anschauen wollen: | |||

while len(q) > 0: | |||

... # 1 | |||

if parents[node] is not None: | |||

continue | |||

parents[node] = predecessor | |||

... # 2 | |||

Wir erkennen, dass der Codeabschnitt <tt># 2</tt> für jeden Knoten höchstens einmal erreicht werden kann: Da <tt>parents[node]</tt> beim ersten Durchlauf gesetzt wird, kann die <tt>if</tt>-Abfrage beim gleichen Knoten nie wieder <tt>False</tt> liefern, und das nachfolgende <tt>continue</tt> bewirkt, dass der Abschnitt <tt># 2</tt> dann übersprungen wird. Man sagt auch, dass jeder Knoten <i>höchstens einmal expandiert</i> wird, auch wenn er mehrmals im Heap war. | |||

* | Der Codeabschnitt <tt># 2</tt> selbst enthält eine Schleife über alle ausgehenden Kanten des Knotens <tt>node</tt>. Im ungünstigsten Fall iterieren wir bei <i>allen</i> Knoten über <i>alle</i> ausgehenden Kanten, aber das sind gerade alle Kanten des Graphen je einmal in den beiden möglichen Richtungen. Die Funktion <tt>heappush</tt> wird sogar höchstens E Mal aufgerufen, weil eine Kante nur in den Heap eingefügt wird, wenn der kürzeste Weg der jeweiligen Endknotens noch nicht bekannt ist (siehe die <tt>if</tt>-Abfrage in der <tt>for</tt>-Schleife), und das ist nur ein einer Richtung möglich. Dies hat zwei Konsequenzen: | ||

* Die Schleife <tt>while len(q) > 0:</tt> wird nur so oft ausgeführt, wie Elemente im Heap sind, also höchstens E Mal. Das gleiche gilt für den Codeabschnitt <tt># 1</tt>, der das <tt>heappop</tt> enthält. | |||

* Die Operationen <tt>heappush</tt> und <tt>heappop</tt> haben logarithmische Komplexität in der Größe des Heaps, sind also in <math>O(\log\,E)</math>. In einfachen Graphen gilt aber <math>E = O(V^2)</math>, so dass sich die Komplexität der Heapoperationen vereinfacht zu <math>O(\log\,E)=O(\log\,V^2)=O(2\log\,V)=O(\log\,V)</math>. | |||

Zusammenfassend gilt: <tt>heappush</tt> und <tt>heappop</tt> werden maximal E Mal aufgerufen und haben eine Komplexität in <math>O(\log\,V)</math>. Folglich hat der Algorithmus von Dijkstra die Komplexität: | |||

:<math>O(E\,\log\,V)</math> | |||

==== Vergleich mit Breitensuche und Tiefensuche ==== | |||

Der Dijkstra-Algorithmus ist eng mit der Breiten- und Tiefensuche verwandt - man kann diese Algorithmen aus dem Dijkstra-Algorithmus gewinnen, indem man einfach die Regel zur Festlegung der Prioritäten ändert. Anstelle der Länge des Pfades verwenden wir als Priorität den Wert eine Zählvariable <tt>count</tt>, die nach jeder Einfügung in den Heap (also nach jedem Aufruf von <tt>heappush</tt>) aktualisiert wird. Zählen wir die Variable hoch, haben die zuerst eingefügten Kanten die höchste Priorität, der Heap verhält sich also wie eine Queue (First in-First out), und wir erhalten eine Breitensuche. Zählen wir die Variable hingegen (von E beginnend) herunter, haben die zuletzt eingefügten Kanten höchste Priorität. Der Heap verhält sich dann wie ein Stack (Last in-First out), und wir bekommen Tiefensuche. Statt eines Heaps plus Zählvariable kann man jetzt natürlich direkt eine Queue bzw. einen Stack verwenden. Dadurch fällt der Aufwand <math>O(\log\,V)</math> für die Heapoperationen weg und wird durch die effizienten O(1)-Operationen von Queue bzw. Stack ersetzt. Damit erhalten wir für Breiten- und Tiefensuche die schon bekannte Komplexität O(E). | |||

==== Korrektheit von Dijkstra ==== | ==== Korrektheit von Dijkstra ==== | ||

Wir beweisen zunächst eine wichtige Eigenschaft des Algorithmus: Die Priorität (=Pfadlänge) des Knotens an der Spitze des Heaps wächst im Laufe des Algorithmus monoton an (aber nicht notwendigerweise streng monoton). Mit anderen Worten: liefert <tt>heappop</tt> in der i-ten Iteration der <tt>while</tt>-Schleife den Knoten u mit der Pfadlänge l<sub>u</sub>, und in der (i+1)-ten Iteration den Knoten v mit der Pfadlänge l<sub>v</sub>, so gilt stets l<sub>v</sub> ≥ l<sub>u</sub>. Wir zeigen dies mit der Technik des indirekten Beweises, d.h. wir nehmen das Gegenteil an und führen diese Annahme zum Widerspruch. Wäre also l<sub>v</sub> < l<sub>u</sub>, gäbe es zwei Möglichkeiten: | |||

<ol> | |||

<li>Der Weg nach v mit der Länge l<sub>v</sub> war in der i-ten Iteration schon bekannt und somit bereits im Heap enthalten. Dann hätte <tt>heappop</tt> in dieser Iteration aber v zurückgegeben, im Widerspruch zur Annahme, dass u zurückgegeben wurde.</li> | |||

<li>Der Weg wurde erst bei der Expansion von u in der i-ten Iteration gefunden. Dann muss v ein Nachbar von u sein, und seine Weglänge berechnet sich als l<sub>v</sub> = l<sub>u</sub> + w<sub>u,v</sub>. Da für die Kantengewichte aber w<sub>u,v</sub> ≥ 0 gefordert ist, kann l<sub>v</sub> < l<sub>u</sub> nicht gelten.</li> | |||

</ol> | |||

Diese Monotonieeigenschaft hat eine interessante Konsequenz: Beträgt der Abstand vom Start zum Zielknoten l<sub>z</sub>, so findet Dijsktra's Algorithmus als Nebenprodukt auch die kürzesten Wege zu allen näher gelegenen Knoten, also zu allen Knoten u, für deren Abstand l<sub>u</sub> < l<sub>z</sub> gilt. Dies trifft auch dann zu, wenn diese Wege für den Benutzer gar nicht von Interesse sind. Der A*-Algorithmus, der weiter unten erklärt wird, versucht dem abzuhelfen. | |||

* | |||

Wir können nun mittels vollständiger Induktion die folgende Schleifen-Invariante beweisen: Falls <tt>parents[node]</tt> gesetzt (also ungleich <tt>None</tt>) ist, dann liefert das Zurückverfolgen des Weges von <tt>node</tt> nach <tt>startnode</tt> den kürzesten Weg. | |||

;Induktionsanfang: <tt>parents[startnode]</tt> ist als einziges gesetzt. Zurückverfolgen liefert den trivialen Weg <tt>[startnode]</tt>, der mit Länge 0 offensichtlich der kürzeste Pfad ist → die Bedingung ist erfüllt. | |||

;Induktionsschritt: Wir zeigen wieder mit einem indirektem Beweis, dass wir immer einen kürzesten Weg bekommen, wenn <tt>parents[node]</tt> gesetzt wird. | |||

:Sei <math>S</math> = <tt>{v | parents[v] is not None}</tt> die Menge aller Knoten, von denen wir den kürzesten Weg schon kennen (Induktionsvoraussetzung), und <tt>node</tt> der Knoten, der sich gerade an der Spitze des Heaps befindet. Dann ist <tt>predecessor</tt> der Vorgänger von <tt>node</tt> im aktuellen Weg, und es muss <tt>predecessor</tt><math>\in S</math> gelten, weil die Nachbarn von <tt>predecessor</tt> (und damit auch der aktuelle <tt>node</tt>) erst in dem Momemnt in den Heap eingefügt werden, wo der kürzeste Weg für <tt>predecessor</tt> gefunden wurde. Man beachte auch, dass wegen der Monotonieeigenschaft alle Knoten, die noch nicht in <math>S</math> enthalten sind, weiter vom Start entfernt sind als die Knoten in <math>S</math>. | |||

:Der indirekte Beweis nimmt jetzt an, dass der Weg <tt>node</tt> → <tt>predecessor</tt> → <tt>startnode</tt> nicht der kürzeste Weg ist. Dann muss es einen anderen, kürzeren Weg <tt>node</tt> → <tt>x</tt> → <tt>startnode</tt> geben. Für den Vorgänger <tt>x</tt> in diesem Weg unterscheiden wir zwei Fälle: | |||

:* <tt>x</tt><math>\in S</math>: In diesem Fall ist die Länge des Weges <tt>node</tt> → <tt>x</tt> → <tt>startnode</tt> bereits bekannt, und dieser Weg ist im Heap enthalten. Dann kann er aber nicht der kürzeste sein, denn an der Spitze der Warteschlange war nach Voraussetzung der Weg <tt>node</tt> → <tt>predecessor</tt> → <tt>startnode</tt>. | |||

:* <tt>x</tt><math>\notin S</math>: Wegen der Monotonieeigenschaft muss jetzt <tt>Kosten(x → startnode) > Kosten(node → predecessor → startnode)</tt> gelten. Die Kosten des Weges <tt>node</tt> → <tt>x</tt> → <tt>startnode</tt> berechnen sich aber als <tt>Kosten(x → startnode) + weight[(x, node)]</tt>, und deshalb kann dieser Weg keinesfalls kürzer sein. | |||

In beiden Fällen erhalten wir einen Widerspruch, und die Behauptung ist somit bewiesen. Da die Invariante insbesondere für den Weg zum Zielknoten <tt>destination</tt> erfüllt ist, folgt daraus auch die Korrektheit des Algorithmus von Dijkstra. | |||

* | === A*-Algorithmus - Wie kann man Dijkstra noch verbessern? === | ||

Eine wichtige Eigenschaft des Dijkstra-Algorithmus ist, dass neben dem kürzesten Weg vom Start zum Ziel auch die kürzesten Wege zu allen Knoten berechnet werden, die näher am Startknoten liegen als das Ziel, obwohl uns diese Wege gar nicht interessieren. Sucht man beispielsweise in einem Graphen mit den Straßenverbindungen in Deutschland den kürzesten Weg von Frankfurt (Main) nach Dresden (ca. 460 km), werden auch die kürzesten Wege von Frankfurt nach Köln (190 km), Dortmund (220 km) und Stuttgart (210 km) und vielen anderen Städten gefunden. Aufgrund der geographischen Lage dieser Städte ist eigentlich von vornherein klar, dass sie mit dem kürzesten Weg nach Dresden nicht das geringste zu tun haben. Anders sieht es mit Erfurt (260 km) oder Suhl (210 km) aus - diese Städte liegen zwischen Frankfurt und Dresden und kommen deshalb als Zwischenstationen des gesuchten Weges in Frage. | |||

Damit Dijkstra korrekt funktioniert, würde es im Prinzip ausreichen, wenn man die kürzesten Wege nur für diejenigen Knoten ausrechnet, die auf dem kürzesten Weg vom Start zum Ziel liegen, denn nur diese Knoten braucht man, um den gesuchten Weg über die <tt>parent</tt>-Kette zurückzuverfolgen. Das Problem ist nur, dass man diese Knoten erst kennt, wenn der Algorithmus fertig durchgelaufen ist. Schließt man Knoten zu früh von der Betrachtung aus, kommt am Ende möglicherweise nicht der korrekte kürzeste Weg heraus. | |||

* | Der A*-Algorithmus löst dieses Dilemma mit folgender Idee: Ändere die Prioritäten für den Heap so ab, dass unwichtige Knoten nur mit geringerer Wahscheinlichkeit expandiert werden, aber stelle gleichzeitig sicher, dass alle wichtigen Knoten (also diejenigen auf dem korrekten kürzesten Weg) auf jeden Fall expandiert werden. Es zeigt sich, dass man diese Idee umsetzen kann, wenn eine <i>Schätzung für den Restweg</i> (also für die noch verbleibende Entfernung von jedem Knoten zum Ziel) verfügbar ist: | ||

rest = guess(neighbor, destination) | |||

Diese Schätzung addiert man einfach zur wahren Länge des Weges <tt>startnode → node</tt> dazu, um die verbesserte Priorität zu erhalten: | |||

priority = newLength + guess(neighbor, destination) | |||

(Im originalen Dijkstra-Algorithmus wird als Priorität nur <tt>newLength</tt> allein verwendet. Man beachte, dass man <tt>newLength</tt> jetzt zusätzlich im Heap speichern muss, weil man es für die Expansion des Knotens später noch benötigt.) | |||

Damit sicher gestellt ist, dass der A*-Algorithmus immer noch die korrekten kürzesten Wege findet, darf die Schätzung den wahren Restweg <i>niemals überschätzen</i>. Es muss immer gelten: | |||

0 <= guess(node, destination) <= trueDistance(node, destination) | |||

Damit gilt insbesondere <tt>guess(destination, destination) = trueDistance(destination, destination) = 0</tt>, an der Priorität des Knotens <tt>destination</tt> ändert sich also nichts. Die Prioritäten aller anderen Knoten veschlechtern sich hingegen, weil zur bisherigen Priorität noch atwas addiert wird. Für die wichtigen Knoten auf dem kürzesten Weg vom Start nach Ziel gilt jedoch, dass deren neue Priorität immer noch besser ist als die Priorität des Zielknotens selbst. Für diese Knoten gilt nämlich | |||

falls node auf dem kürzesten Weg von startnode nach destination liegt: | |||

trueDistance(startnode, node) + guess(node, destination) <= trueDistance(startnode, destination) | |||

weil der Weg von Start nach <tt>node</tt> ein Teil des kürzesten Wegs von Start nach Ziel ist und die Restschätzung die wahre Entfernung immer unterschätzt. Diese Knoten werden deshalb stets vor dem Zielknoten expandiert, so dass wir die <tt>parent</tt>-Kette immer noch korrekt zurückverfolgen können. Für alle anderen Knoten gilt idealerweise, dass die neue Priorität schlechter ist als die Priorität von <tt>destination</tt>, so dass man sich diese irrelevanten Knotenexpansionen sparen kann. | |||

Für das Beispiel eines Straßennetzwerks bietet sich als Schätzung die Luftlinienentfernung an, weil Straßen nie kürzer sein können als die Luftlinie. Damit erreicht man in der Praxis deutliche Einsparungen. Generell gilt, dass der A*-Algorithmus im typischen Fall schneller ist als der Algorithmus von Dijkstra, aber man kann immer pathologische Fälle konstruieren, wo die Änderung der Prioritäten nichts bringt. Die Komplexität des A*-Algorithmus im ungünstigen Fall ist deshalb nach wie vor <math>O(E\,\log\,V)</math>. | |||

=='''Minimaler Spannbaum'''== | =='''Minimaler Spannbaum'''== | ||

'''(engl.: minimum spanning tree; abgekürzt: MST)''' | '''(engl.: minimum spanning tree; abgekürzt: MST)''' | ||

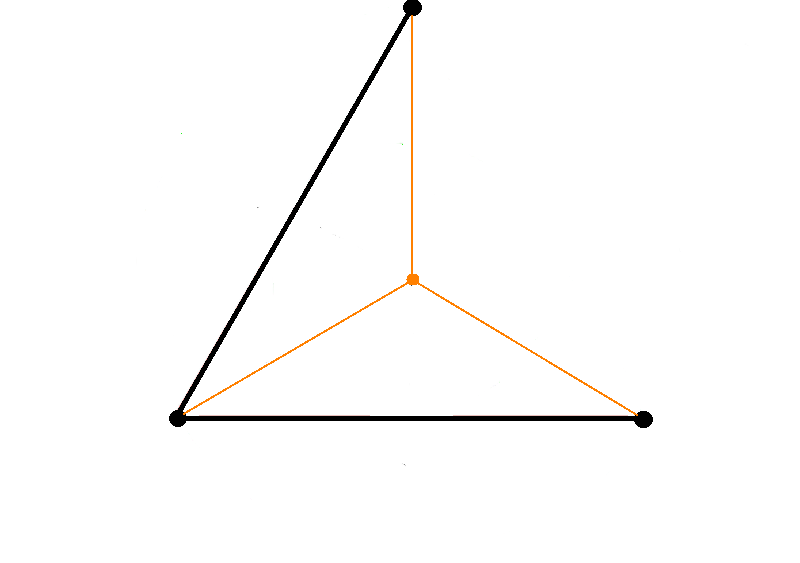

[[Image:Minimum_spanning_tree.png |thumb|200px|right|Ein minimal aufspannender Baum verbindet alle Punkte eines Graphen bei minimaler Kantenlänge ([http://de.wikipedia.org/wiki/Spannbaum Quelle])]] | |||

:<u>''gegeben''</u>: gewichteter Graph, zusammenhängend<br/> | :<u>''gegeben''</u>: gewichteter Graph G, zusammenhängend<br/> | ||

:<u>''gesucht''</u>: Untermenge <math>E'\subseteq E</math>, so dass <math>\sum_{e\in E} w_e</math> minimal und G' zusammenhängend ist. <br/> | :<u>''gesucht''</u>: Untermenge <math>E'\subseteq E</math> der Kanten, so dass die Summe der Kantengewichte <math>\sum_{e\in E'} w_e</math> minimal und der entstehende Graph G' zusammenhängend ist.<br/> | ||

* G'definiert | * G' definiert immer einen Baum, denn andernfalls könnte man eine Kante weglassen und dadurch die Summe <math>\sum_{e\in E'} w_e</math> verringern, ohne dass sich am Zusammenhang von G' etwas ändert. <br/> | ||

* Wenn der Graph G nicht zusammenhängend ist, kann man den Spannbaum für jede Zusammenhangskomponente getrennt ausrechnen. Man erhält dann einen aufspannenden Wald. | |||

* Der MST ist ähnlich wie der Dijkstra-Algorithmus: Dort ist ein Pfad gesucht, bei dem die Summe der Gewichte über den Pfad minimal ist. Beim MST suchen wir eine Lösung, bei der die Summe der Gewichte über den ganzen Graphen minimal ist. | |||

* Das Problem des MST ist nahe verwandt mit der Bestimmung der Zusammenhangskomponente, z.B. über den Tiefensuchbaum. Für die Zusammenhangskomponenten genügt allerdings ein beliebiger Baum, während beim MST ein minimaler Baum gesucht ist. | |||

=== Anwendungen === | |||

==== Wie verbindet man n gegebene Punkte mit möglichst kurzen Straßen (Eisenbahnen, Drähten [bei Schaltungen] usw.)?==== | |||

<br/><br/><br/> | <br/><br/><br/> | ||

| Line 892: | Line 890: | ||

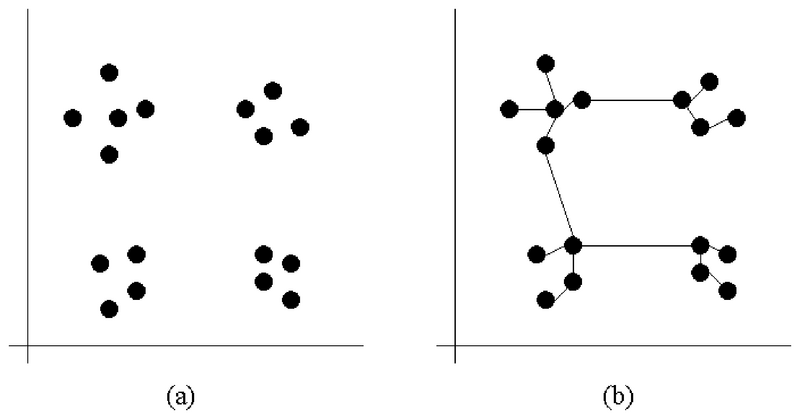

==== Bestimmung von Datenclustern ==== | |||

| Line 906: | Line 904: | ||

* Wenn man geschickt eine Schwelle einführt und alle Kanten löscht, die länger sind als die Schwelle, dann bekommt man als Zusammenhangskomponente die einzelnen Gruppen. | * Wenn man geschickt eine Schwelle einführt und alle Kanten löscht, die länger sind als die Schwelle, dann bekommt man als Zusammenhangskomponente die einzelnen Gruppen. | ||

=== Algorithmen === | |||

Genau wie bei der Bestimmung von Zusammenhangskomponenten kann man auch das MST-Problem entweder nach dem Anlagerungsprinzip oder nach dem Verschmelzungsprinzip lösen (dazu gibt es noch weitere Möglichkeiten, z.B. den [http://de.wikipedia.org/wiki/Algorithmus_von_Bor%C5%AFvka Algorithmus von Boruvka]). Der Anlagerungsalgorithmus für MST wurde zuerst von Prim beschrieben und trägt deshalb seinen Namen, der Verschmelzungsalgorithmus stammt von Kruskal. Im Vergleich zu den Algorithmen für Zusammenhangskomponenten ändert sich im wesentlichen nur die Reihenfolge, in der die Kanten betrachtet werden: Eine Prioritätswarteschlange stellt jetzt sicher, dass am Ende wirklich der Baum mit den geringstmöglichen Kosten herauskommt. | |||

( | |||

====Algorithmus von Prim==== | ====Algorithmus von Prim==== | ||

[http://de.wikipedia.org/wiki/Algorithmus_von_Prim | [http://de.wikipedia.org/wiki/Algorithmus_von_Prim Wikipedia (de)] | ||

[http://en.wikipedia.org/wiki/Prim%27s_algorithm (en)] | [http://en.wikipedia.org/wiki/Prim%27s_algorithm (en)] | ||

: | Der Algorithmus von Prim geht nach dem Anlagerungsprinzip vor (vgl. den Abschnitt [[Graphen_und_Graphenalgorithmen#Lösung mittels Tiefensuche|Zusammenhangskomponenten mit Tiefensuche]]): Starte an der Wurzel (ein willkürlich gewählter Knoten) und füge jeweils die günstigste Kante an die aktuellen Teillösung an, die keinen Zyklus verursacht. Die Sortierung der Kanten nach Priorität erfolgt analog zum Dijsktra-Algorithmus, aber die Definitionen, welche Kante die günstigste ist, unterscheiden sich. Die Konvention für die Bedeutung der Elemente des Heaps ist ebenfalls identisch: ein Tupel mit <tt>(priority, node, predecessor)</tt>. Die folgende Implementation verdeutlicht sehr schön die Ähnlichkeit der beiden Algorithmen. Das Ergebnis wird als property map <tt>parents</tt> zurückgegeben, in der für jeden Knoten sein Vorgänger im MST steht, wobei die Wurzel wie üblich auf sich selbst verweist. | ||

import heapq | import heapq | ||

def prim(graph): | |||

def prim(graph, weights): # Kantengewichte wie bei Dijkstra als property map | |||

sum = 0.0 # wird später das Gewicht des Spannbaums sein | |||

start = 0 # Knoten 0 wird willkürlich als Wurzel gewählt | |||

parents = [None]*len(graph) # property map, die den resultierenden Baum kodiert | |||

parents[start] = start # Wurzel zeigt auf sich selbst | |||

heap = [] # Heap für die Kanten des Graphen | |||

for neighbor in graph[start]: # besuche die Nachbarn von start | |||

heapq.heappush(heap, (weights[(start, neighbor)], neighbor, start)) # und fülle Heap | |||

while len(heap) > 0: | |||

w, node, predecessor = heapq.heappop(heap) # hole billigste Kante aus dem Heap | |||

if parents[node] is not None: # die Kante würde einen Zyklus verursachen | |||

continue # => ignoriere diese Kante | |||

parents[node] = predecessor # füge Kante in den MST ein | |||

sum += w # und aktualisiere das Gesamtgewicht | |||

for neighbor in graph[node]: # besuche die Nachbarn von node | |||

if parents[neighbor] is None: # aber nur, wenn kein Zyklus entsteht | |||

heapq.heappush(heap, (weights[(node,neighbor)], neighbor, node)) # füge Kandidaten in Heap ein | |||

return parents, sum # MST und Gesamtgewicht zurückgeben | |||

====Algorithmus von Kruskal==== | ====Algorithmus von Kruskal==== | ||

| Line 940: | Line 943: | ||

[http://en.wikipedia.org/wiki/Kruskal%27s_algorithm (en)] | [http://en.wikipedia.org/wiki/Kruskal%27s_algorithm (en)] | ||

Die alternative Vorgehensweise ist das Verschmelzungsprinzip (vgl. den Abschnitt [[Graphen_und_Graphenalgorithmen#Lösung mittels Union-Find-Algorithmus|Zusammenhangskomponenten mit Union-Find-Algorithmus]]), das der Algorithmus von Kruskal verwendet. Jeder Knoten wird zunächst als trivialer Baum mit nur einem Knoten betrachtet, und alle Kanten werden aufsteigend nach Gewicht sortiert. Dann wird die billigste noch nicht betrachtete Kante in den MST eingefügt, falls sich dadurch kein Zyklus bildet (erkennbar daran, dass die Endknoten in verschiedenen Zusammenhangskomponenten liegen, das heisst verschiedene Anker haben). Da der fertige Baum (V-1) Kanten haben muss, wird dies (V-1) Mal zutreffen. Andernfalls wird diese Kante ignoriert. Anders ausgedrückt: Der Algorithmus beginnt mit ''V'' Bäumen; in (''V''-1) Verschmelzungsschritten kombiniert er jeweils zwei Bäume (unter Verwendung der kürzesten möglichen Kante), bis nur noch ein Baum übrig bleibt. Der einzige Unterschied zum einfachen Union-Find besteht darin, dass die Kanten in aufsteigender Reihenfolge betrachtet werden müssen, was wir hier durch eine Prioritätswarteschlange realisieren. Der Algorithmus von J.Kruskal ist seit 1956 bekannt. | |||

Der Algorithmus von J.Kruskal ist seit 1956 bekannt. | |||

def kruskal(graph, weights): | |||

anchors = range(len(graph)) # Initialisierung der property map: jeder Knoten ist sein eigener Anker | |||

# | results = [] # result wird später die Kanten des MST enthalten | ||

# | |||

heap = [] # Heap zum Sortieren der Kanten nach Gewicht | |||

for edge, w in weights.iteritems(): # alle Kanten einfügen | |||

heapq.heappush(heap, (w, edge)) | |||

while len(heap) > 0: # solange noch Kanten vorhanden sind | |||

w, edge = heapq.heappop(heap) # billigste Kante aus dem Heap nehmen | |||

a1 = findAnchor(anchors, edge[0]) # Anker von Startknoten der Kante | |||

a2 = findAnchor(anchors, edge[1]) # ... und Endknoten bestimmen | |||

if a1 != a2: # wenn die Knoten in verschiedenen Komponenten sind | |||

anchors[a2] = a1 # Komponenten verschmelzen | |||

result.append(edge) # ... und Kante in MST einfügen | |||

return result # Kanten des MST zurückgeben | |||

Die Funktion <tt>findAnchor()</tt> wurde im Abschnitt [[Graphen_und_Graphenalgorithmen#Lösung mittels Union-Find-Algorithmus|Zusammenhangskomponenten mit Union-Find-Algorithmus]] implementiert. Im Unterschied zum Algorithmus von Prim geben wir hier nicht die property map <tt>parents</tt> zurück, sondern einfach eine Liste der Kanten im MST. | |||

Der Algorithmus eignet sich insbesondere für das Clusteringproblem, da der Schwellwert von vornerein als maximales Kantengewicht an den Algorithmus übergeben werden kann. Man hört mit dem Vereinigen auf, wenn das Gewicht der billigste Kante im Heap den Schwellwert überschreitet. Beim Algorithmus von Kruskal kann dann keine bessere Kante als der Schwellwert mehr kommen, da die Kanten vorher sortiert worden sind. | |||

<b>Komplexität:</b> wie beim Dijkstra-Algorithmus, weil jede Kante genau einmal in den Heap kommt. Der Aufwand für das Sortieren ist somit <math>O\left(E\log E\right)</math>, was sich zu <math>O \left(E\,\log\,V\right)</math> reduziert, falls keine Mehrfachkanten vorhanden sind. | |||

=> geeignet für Übungsaufgabe | => geeignet für Übungsaufgabe | ||

== | ====Verwendung einer BucketPriorityQueue==== | ||